- Tác giả Lynn Donovan [email protected].

- Public 2023-12-15 23:55.

- Sửa đổi lần cuối 2025-01-22 17:46.

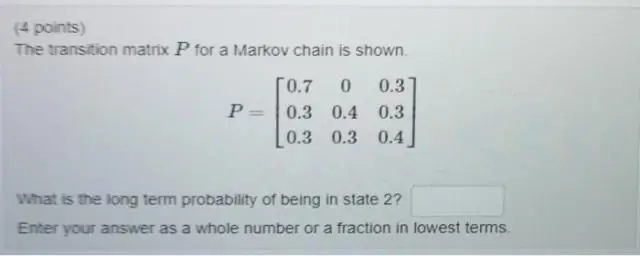

MỘT Chuỗi Markov là một ngẫu nhiên người mẫu mô tả một chuỗi các sự kiện có thể xảy ra trong đó xác suất của mỗi sự kiện chỉ phụ thuộc vào trạng thái đạt được trong sự kiện trước đó.

Theo quan điểm này, bạn nghĩ gì về chuỗi Markov?

MỘT Chuỗi Markov là một hệ thống toán học trải qua quá trình chuyển đổi từ trạng thái này sang trạng thái khác theo các quy tắc xác suất nhất định. Đặc điểm xác định của một Chuỗi Markov đó là không có vấn đề như thế nào tiến trình đến trạng thái hiện tại của nó, các trạng thái có thể có trong tương lai được cố định.

Người ta cũng có thể hỏi, sự khác biệt giữa chuỗi Markov và quy trình Markov là gì? Các sự khác biệt giữa chuỗi Markov và quy trình Markov Là bên trong bộ chỉ mục, dây chuyền có một thời gian rời rạc, quy trình có (thường) liên tục. Các biến ngẫu nhiên rất giống lợn Guinea, không phải lợn, cũng không phải từ Guinea. Biến ngẫu nhiên là các hàm (được xác định theo định nghĩa).

Sau đó, câu hỏi đặt ra là xích Markov được sử dụng để làm gì?

Chuỗi Markov là đã từng tính toán xác suất của các sự kiện xảy ra bằng cách xem chúng là. trạng thái chuyển đổi sang các trạng thái khác, hoặc chuyển đổi sang trạng thái giống như trước đó. Chúng ta có thể. lấy thời tiết làm ví dụ: Nếu chúng ta tự ý chọn xác suất, một dự đoán liên quan đến.

Chuỗi Markov đồng nhất là gì?

markov - tiến trình đồ thị-mô hình đồ thị-lý thuyết. Tôi đã học được rằng một Chuỗi Markov là biểu đồ mô tả trạng thái thay đổi như thế nào theo thời gian và chuỗi Markov đồng nhất là một đồ thị sao cho động hệ thống của nó không thay đổi.

Đề xuất:

Thẻ nào có thể được sử dụng để xác định phương thức do người dùng xác định trong JSP?

Thẻ khai báo là một trong những phần tử kịch bản trong JSP. Thẻ này được sử dụng để khai báo các biến. Cùng với đó, Thẻ khai báo cũng có thể khai báo phương thức và các lớp. Trình khởi tạo jsp quét mã và tìm thẻ khai báo và khởi tạo tất cả các biến, phương thức và lớp

Chuỗi khối được sử dụng như thế nào trong chuỗi cung ứng?

Theo dõi thời gian thực của một sản phẩm trong chuỗi cung ứng với sự trợ giúp của blockchain làm giảm chi phí tổng thể của việc di chuyển các mặt hàng trong chuỗi cung ứng. Các khoản thanh toán có thể được xử lý bởi khách hàng và nhà cung cấp trong chuỗi cung ứng bằng cách sử dụng tiền điện tử thay vì khách hàng và nhà cung cấp khác hơn là dựa vào EDI

Sự khác biệt giữa chuỗi và chuỗi trong C # là gì?

Sự khác biệt giữa chuỗi và chuỗi trong C # Trong C #, chuỗi là một bí danh cho lớp String trong khung. NET. Sự khác biệt nhỏ duy nhất là nếu bạn sử dụng lớp String, bạn cần nhập không gian tên Hệ thống trên đầu tệp của mình, trong khi bạn không phải làm điều này khi sử dụng từ khóa string

Phương thức chuỗi nào được sử dụng để so sánh hai chuỗi với nhau trong C #?

Cú pháp của hàm strcmp () là: Cú pháp: int strcmp (const char * str1, const char * str2); Hàm strcmp () dùng để so sánh hai chuỗi hai chuỗi str1 và str2. Nếu hai chuỗi giống nhau thì hàm strcmp () trả về 0, ngược lại, nó trả về giá trị khác 0

Xác nhận và xác minh trong cơ sở dữ liệu là gì?

Xác minh dữ liệu là một cách để đảm bảo người dùng nhập những gì họ dự định, nói cách khác, để đảm bảo người dùng không mắc lỗi khi nhập dữ liệu. Xác thực là kiểm tra dữ liệu đầu vào để đảm bảo dữ liệu đó phù hợp với yêu cầu dữ liệu của hệ thống để tránh lỗi dữ liệu